新書推薦:

《

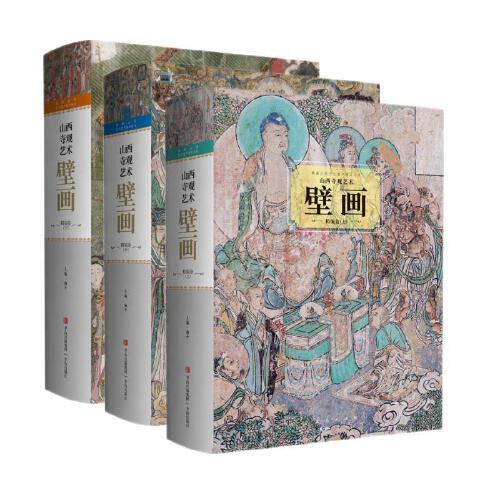

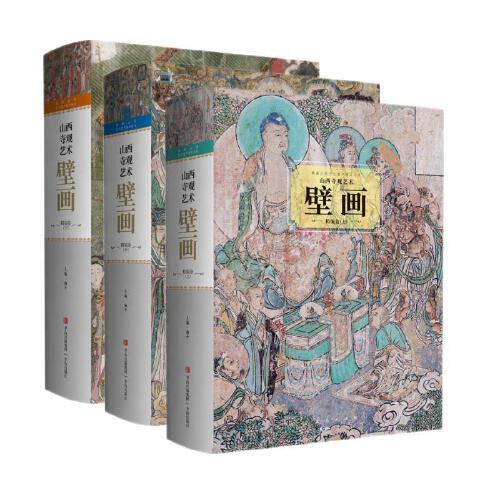

山西寺观艺术壁画精编卷

》

售價:HK$

1680.0

《

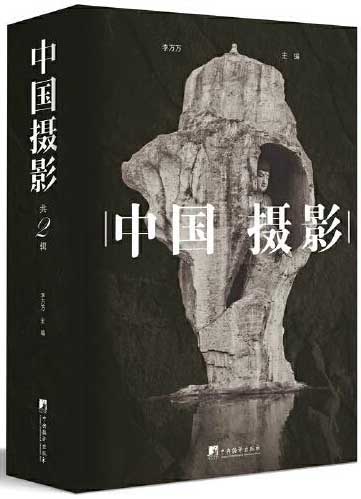

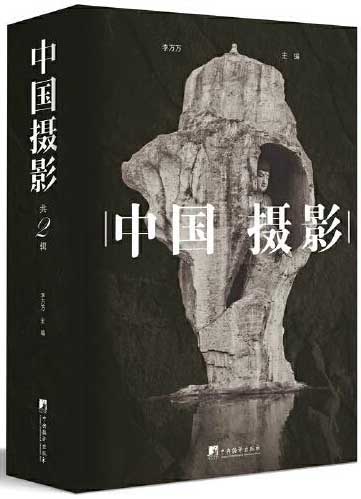

中国摄影 中式摄影的独特魅力

》

售價:HK$

1097.6

《

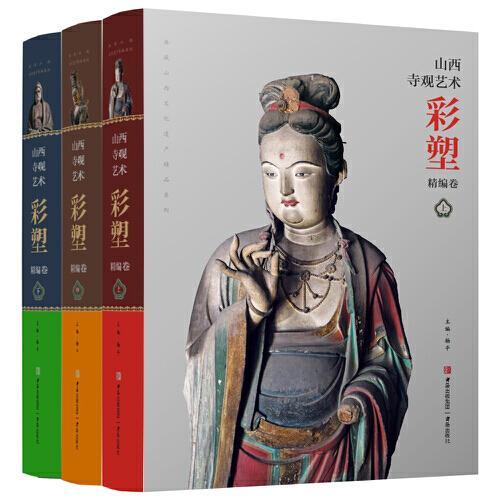

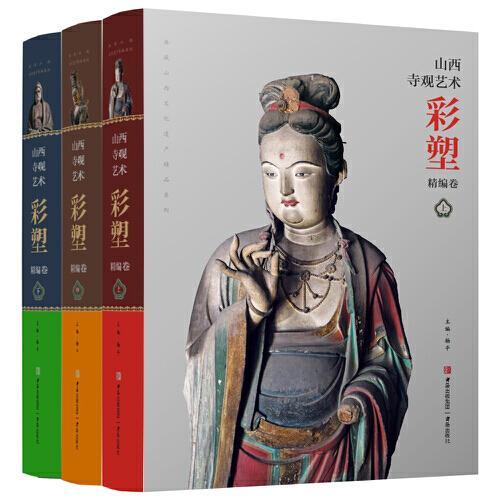

山西寺观艺术彩塑精编卷

》

售價:HK$

1680.0

《

积极心理学

》

售價:HK$

55.8

《

自由,不是放纵

》

售價:HK$

54.9

《

甲骨文丛书·消逝的光明:欧洲国际史,1919—1933年(套装全2册)

》

售價:HK$

277.8

《

剑桥日本戏剧史(剑桥世界戏剧史译丛)

》

售價:HK$

201.6

《

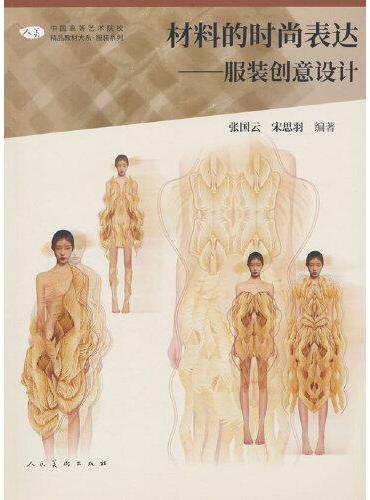

中国高等艺术院校精品教材大系:材料的时尚表达??服装创意设计

》

售價:HK$

76.2

|

| 編輯推薦: |

|

本书针对的是人工智能、机器学习和自动控制中的前沿技术——强化学习,论述了强化学习的基本知识,还阐述了强化学习中的最新学习方法。并结合当下热点—深度学习,对深度学习与强化学习结合的产物—深度强化学习,进行了介绍与展望。同时,本书每章节均配有示例与名人传记,方便读者掌握方法的具体发展过程。

|

| 內容簡介: |

|

强化学习是目前机器学习乃至人工智能领域发展最快的分支之一。强化学习的基本思想是通过与环境的交互、智能体或智能算法获取相关智能,其具体过程就是根据环境反馈得到的奖励不断调整自身的策略进而获得**奖励决策的学习历程。本书主要讲述了强化学习的基本原理和基本方法,基于强化学习的控制、决策和优化方法设计与理论分析,深度强化学习原理以及平行强化学习等未来强化学习的发展新方向,展示从先行后知到先知后行,再到知行合一的混合平行智能思路。 本书可作为高等学校人工智能、机器学习、智能控制、智能决策、智慧管理、系统工程以及应用数学等专业的本科生或研究生教材,亦可供相关专业科研人员和工程技术人员参考。

|

| 目錄:

|

第1章强化学习概论

1.1引言

1.2强化学习的发展历程

1.3强化学习的研究现状

1.4本书内容架构

参考文献

第2章马尔可夫决策过程

2.1马尔可夫决策过程

2.2策略与代价函数

2.3最优策略与最优代价函数

参考文献

第3章动态规划

3.1动态规划的兴起

3.2动态规划基本思想: 多级决策过程

3.3最优性原理与递推方程

3.4离散时间动态规划

3.5连续时间动态规划

3.6动态规划的挑战

参考文献

第4章蒙特卡洛学习方法

4.1蒙特卡洛方法背景

4.1.1蒙特卡洛方法的由来

4.1.2基于模型的算法与无模型算法比较

4.1.3蒙特卡洛模拟的思路

4.2蒙特卡洛预测

4.2.1初次访问蒙特卡洛预测

4.2.2历次访问蒙特卡洛预测

4.2.3增量计算技巧

4.3蒙特卡洛控制

4.3.1初始探索问题

4.3.2在策方法: ε贪心算法

4.3.3脱策算法: 重要性采样

4.4蒙特卡洛强化学习算法总结

参考文献

第5章时序差分学习

5.1时序差分学习基本概念

5.2时序差分学习算法

5.3n步回报

5.4TD(λ)算法

参考文献

第6章神经网络

6.1神经网络的发展历史

6.2MP神经元模型

6.3前馈神经网络

6.3.1感知机

6.3.2误差反向传播算法

6.3.3径向基网络

6.4其他常见的神经网络

6.4.1ART网络

6.4.2Hopfield网络

6.4.3Boltzmann机

参考文献

第7章自适应动态规划

7.1问题描述

7.2自适应动态规划的原理

7.3自适应动态规划的分类

7.3.1启发式动态规划

7.3.2二次启发式规划

7.3.3执行依赖启发式动态规划

7.3.4执行依赖二次启发式规划

7.4基于执行依赖的自适应动态规划方法

7.4.1问题描述

7.4.2基于执行依赖的自适应动态规划方法

参考文献

第8章策略迭代学习方法

8.1启发式学习原理

8.2离散时间策略迭代自适应动态规划

8.2.1策略迭代算法的推导

8.2.2策略迭代算法的性质

8.2.3初始容许控制律的获得

8.2.4仿真实验

8.3连续时间策略迭代自适应动态规划

8.3.1连续时间策略迭代算法

8.3.2连续时间策略迭代自适应动态规划的性能分析

参考文献

第9章值迭代学习方法

9.1值迭代学习原理

9.2离散时间值迭代自适应动态规划

9.2.1离散时间非线性系统的Bellman方程解

9.2.2广义值迭代自适应动态规划

9.3连续时间值迭代自适应动态规划

9.3.1问题描述

9.3.2主要结果

参考文献

第10章Q学习方法

10.1无模型强化学习

10.2Q学习原理

10.3离散时间确定性Q学习

10.3.1问题描述

10.3.2离散时间确定性Q学习算法的性质

10.3.3离散时间确定性Q学习算法的神经网络实现

10.3.4仿真实验

10.4Q学习进展

参考文献

第11章脱策学习

11.1脱策学习的兴盛

11.2脱策学习的基本思想

11.2.1问题描述

11.2.2相关研究工作

11.3脱策学习过程

11.3.1脱策强化学习

11.3.2基于神经网络的实现

11.4脱策学习收敛性分析

11.5基于脱策强化学习的线性H∞控制

11.6仿真实验

参考文献

第12章深度强化学习

12.1深度学习基本概念

12.1.1深度学习的起源

12.1.2深度学习与传统机器学习

12.1.3深度学习的运用环境

12.2深度神经网络

12.2.1深度神经网络溯源

12.2.2梯度下降法

12.2.3反向传播

12.2.4动量模型

12.2.5学习律

12.3卷积神经网络

12.3.1卷积神经网络介绍

12.3.2卷积层

12.3.3采样层

12.3.4分类层

12.3.5经典卷积神经网络结构

12.4循环神经网络

12.4.1循环神经网络介绍

12.4.2长短期记忆模型

12.5生成对抗网络

12.6深度强化学习基本理论

12.6.1Q函数

12.6.2策略

12.6.3效用值

12.6.4模型

12.6.5规划

12.7深度强化学习实际应用

12.7.1游戏

12.7.2机器人与控制

12.7.3自然语言处理

12.7.4计算机视觉

12.8未来待解决的问题

12.8.1采样效率低下

12.8.2难以寻找合适的效用函数

12.8.3局部最优陷阱

12.8.4过拟合问题

12.8.5复现难题

12.8.6适用场景与未来思考

参考文献

第13章强化学习展望: 平行强化学习

13.1自适应动态规划与深度强化学习

13.2平行控制理论的基本思想

13.3平行动态规划方法

参考文献

|

| 內容試閱:

|

强化学习: 迈向知行合一的智能机制与算法

人工智能的异军突起,除计算能力和海量数据外,最大的贡献者当属机器学习,其中最引人注目的核心技术与基础方法就是深度学习和强化学习(Reinforcement Learning),前者是台前的“明星”,后者是幕后的“英雄”。与新兴的深度学习相比,强化学习相对“古老”,其思想源自人类“趋利避害”和“吃一堑、长一智”的朴素意识,其最初的“尝试法”或“试错法”,远在人工智能技术出现之前就在各行各业广为流行,并成为人工智能起步时的核心技术之一。AlphaGo在围棋人机大战取得的胜利,使社会大众普遍认识到有监督的深度学习和无监督的强化学习的威力。近年来,人工智能算法在一些多角色游戏中大胜人类顶级专业选手,更使人们对强化学习的功能有了更加深刻的印象和理解。

例如,以强化学习为核心技术之一的人工智能系统Pluribus在六人桌无限制的得州扑克比赛中,在一万手回合里分别以其单机对五人和五机对单人的方式,共击败15名全球最佳专业玩家,突破了过去人工智能仅能在国际象棋等二人游戏中战胜人类的局限,成为游戏中机器胜人又一个里程碑性的事件,被《科学》杂志评选为2019年十大科学突破之一。Pluribus这项工作之所以重要的主要原因是:

人工智能算法必须处理不完备信息,需要在不知对手策略和资源的情况下进行决策,并在不同博弈之间寻求平衡;

博弈最佳的理论结果是纳什平衡,但随着玩家数目的增加,求解纳什平衡的计算复杂度呈指数级增长,算法要求的算力在物理上不可能实现,必须引入智力;

掌握“诈唬”等心理技巧是游戏胜利的关键之一,必须考虑并采用此类心理“算计”,在博弈中有效推理并隐藏意图,产生让对手难以预测和分析的策略。

这些问题及其解决方案,正是人工智能进一步发展所必须面对的核心任务,也是强化学习之所以关键的主要因素。这些问题的有效解决和广泛应用,不但可为多角色、多玩家场景下的博弈和电子竞技做出贡献,更将为人工智能在工业控制、商务决策、企业管理和军事控制等重大领域的大规模实际应用,提供有效的方法和坚实的技术支撑。

强化学习为何有如此强大的功能和作用?其实强化学习的发展经历了漫长而曲折的道路,与有监督的学习方法不同,强化学习面对的是更加复杂艰巨且“不知对错、无论好坏”的学习任务: 决策或行动实施之前,没有关于正确与错误的理性推断判据; 决策实施之后,又没有关于好与坏的客观评价依据。然而,一百年来,科学家们坚持不懈,尝试了许多的方法,从经典的条件反射(Classical Conditioning)、试错法(Trial and Error)等“先行后知”的动物学习方法,到系统模型、价值函数、动态规划、学习控制等“先知后行”的最优控制方法,直到今天集估计、预测、自适应等于一体的时序差分(Temporal Difference)学习方法。目前,强化学习正整合算力、数据、知识图谱、逻辑推理、智能控制和知识自动化等技术,统一分析现状、回顾、展望等因素,迈向“知行合一”的复杂自适应智能机制与算法体系。图1给出由F.Woergoetter和B.Porr总结的强化学习的整体过程,比较完整地反映了这一方法的核心内容及其相关问题。

图1强化学习的核心内容与相关问题

先行后知的起步

作为一项科学研究,强化学习始于“摸着石头过河”的启发式思维,在学术文献上可追溯到英国著名学者Alexander Bain(1818—1903)的《摸索与实验》(Groping and Experiment)学习原理。Bain是著名杂志Mind的创办人,正是这份杂志于1950年发表了图灵的《计算机器与智能》(Computing Machinery and Intelligence),提出“图灵测试”判断机器智能水平,开启了人工智能研究领域。作为一个方法,强化学习源自“试错学习”(Trial and Error Learning),由英国生物和心理学家Conway Morgan(1852—1936)正式提出,并以“摩根法则”(Morgan’s Canon)为指导原则,即尽可能用低级心理功能解释生物行为的节约原则,后被美国心理学家、学习理论专家、联结主义创始人之一Edward Thorndike(1874—1949)进一步简化为“效果定律”(Law of Effect),成为后来的学习规则Hebb定律和神经网络误差反向传播BP算法的鼻祖。强化学习的正式出现要归功于苏联生理学家巴甫洛夫(1849—1936)及其经典条件反射理论和激励响应(StimulusResponse)理论,特别是他通过狗进行的一系列刺激反应试验所总结出来的条件反射定律。在美国,心理学家Burrhus Frederic Skinner (1904—1990)提出的工具条件反射(Operant or Instrumental Conditioning)和工具学习(Instrumental Learning)及其利用老鼠进行试验的SkinnerBox 技术, 也推动了强化学习的行为分析试错法研究。

自此之后,强化学习在动物行为研究、生理和心理学以及认知科学等领域发挥了重要作用,成为相应的核心方法与技术。在人工智能之初,从图灵基于效果定律的“快乐痛苦系统”(PleasurePain System),Marvin Minsky(1927—2016)基于强化学习的随机神经模拟强化计算器(Stochastic Neural Analog Reinforcement Calculators,SNARC)及其《迈向人工智能之步》(Steps Toward Artificial Intelligence)一文中提出复杂强化学习的“基本信用(功劳)分配问题”,再到Donald Michie(1933—2007)基于强化学习的MENACE和GLEE学习引擎,Nils Nilsson(1933—2019)学习自动机(Learning Automata)和学习机器(Learning Machines),还有John Holland(1927—2015)的“分类系统”(Classifier Systems)及其遗传算法,强化学习的思想和方法对许多人工智能机制和算法的设计都产生了深刻的影响。然而,相对许多机器学习方法而言,直到21世纪初,人们对强化学习的期望远大于其成果,在相当长的时期里,强化学习实际上并不是人工智能及其相关领域的主流方法和技术。

先知后行的重铸

基于生物和心理学并以试错方法为主的强化学习没有用到太多的数学概念和工具,而且在工程上也没有多少应用,直到20世纪50年代,随着工程数学化的深入和现代控制理论的兴起,特别是基于系统动力学模型的最优控制的出现,加上Richard Bellman(1920—1984)的杰出工作,使强化学习走上了一条数学化和工程应用的崭新道路,局面大为改观: 朴素的奖励惩罚变成了“价值函数(Value Function)”,简单的行为选择升华为“动态规划(Dynamic Programming)”,非线性随机微分方程来了,伊藤积分(Ito Integral)用上了,马尔可夫随机过程成了离散情况下的标配,有时还必须引入博弈论。强化学习从极其具体实在的动物行为学习,突然变为十分复杂抽象的马尔可夫决策过程(Markov Decision Process,MDP)和Bellman方程,甚至更难认知和求解的哈密顿雅可比贝尔曼(HamiltonJacobiBellman,HJB)偏微分方程。一时间,原来“先行后知”的试错行为不见了,代之而来的是“先知后行”式的方程求解,这一下子成为控制理论与工程的一部分,让许多研究者惊奇之余感到希望和曙光的来临。

然而,这道曙光仅带来短暂的黎明,很快又沉于“黑暗”,强化学习在新的道路上刚起步就遭遇“维数灾难(The Curse of Dimensionality)”,当问题变得复杂(维数增加)时,动态规划求解方程的计算量呈指数增加,没有计算机可以应付,强化学习的“先知后行”变得无法施行。

为了克服“维数灾难”,智能这面旗帜被再次举起,使最优控制从以数学推理为主演化为以智能技术为主的学习控制和智能控制。从20世纪60代发展至今,最初的代表人物是美国普渡大学的KingSun Fu(傅京孙,1930—1985)和George N.Saridis(1931—2006),后来两人分别成为模式识别和机器人与自动化领域的创始人和早期开拓者之一。受当时人工智能逻辑化解析化思潮的影响,智能控制在30多年的初创时期主要围绕着形式语言、语法分析、决策自动机、图式学习、随机逼近、蒙特卡洛法、最小二乘、参数识别、自适应算法、自组织系统、迭代学习、强化学习等技术展开,应用于模式识别、机器人与自动化、无人系统、计算机集成制造、金融科技等领域,但无论在规模还是在效益方面都没有完全摆脱“维数灾难”的阴影,其发展到20世纪90年代中期就陷入瓶颈,相关工作几乎停滞不前。

“山重水复疑无路,柳暗花明又一村”。Paul Werbos在20世纪70年代中期推出神经元网络误差反向传播算法的同时,开始研究新优化方法在策略分析中的应用,并于80年代末正式提出近似动态规划(Approximate Dynamic Programming)的思想。同一时期,Saridis和王飞跃也针对非线性确定系统和随机系统提出了类似的次优控制迭代策略。经过Warren B.Powell、Dimitri Panteli Bertsekas、John N.Tsitsiklis等人的发展, 这一方法进一步与神经网络技术结合,从近似动态规划发展到神经动态规划(NeuroDynamic Programming),最后发展到目前的自适应动态规划(Adaptive Dynamic Programming,ADP)。80年代中期以来,王飞跃、刘德荣和魏庆来从不同角度开展了ADP相关工作,经过十余年的努力,形成了中国科学院自动化研究所复杂系统管理与控制国家重点实验室自适应动态规划团体,致力于ADP方法的进一步发展和应用,从智能控制的角度推动了强化学习的理论研究与工程实践。

时序差分的再生

尽管Werbos在20世纪70年代末就试图整合统一试错学习和最优控制的学习方法,但在相当长的时间里,基于这两种方法的强化学习几乎各自独立,没有多少交叉,直到80年代以Andrew G.Barto、Richard S.Sutton和Charles W.Anderson为核心的学者重新推出时序差分(Temporal Difference(TD),也有时间差分的译法,但本意是暂时差别)的概念和方法,局势才开始改变,强化学习渐渐走上“先行后知”与“先知后行”为一统的“知行合一”之途。简言之,时序差分集现状、回顾、展望的不同需求和分析于一体,在试错和规划上充分考虑并利用不同时段的系统预估与环境反馈之间的差别,显著地提高了学习和决策的系统性和效率。由此,强化学习进入时序差分学习阶段,理论研究和工程应用的水平都得到很大的提升。

时序差分学习的理念源自动物学习心理学中与主要强化因子匹配的“次要强化因子(Secondary Reinforces)”概念。Minsky在人工智能之初就认定这一心理学方法对人工学习系统具有重要的意义,计算机游戏博弈技术的开创者Arthur Lee Samuel(1901—1990)在其著名的跳棋程序也采用了时序差分的理念,并由此使“机器学习”一词成为广为人知的术语。20世纪70年代初,A.Harry Klopf(1941—1997)认识到强化学习与监督学习的本质不同,强调强化学习内在的趋利(Hedonistic)特性,试图将试错学习与时序差分学习结合,提出了“局部强化”(Local Reinforcement)和“广义强化”(Generalized Reinforcement)等概念,但与现代的时序差分并不完全相同; 加上A.Harry Klopf英年早逝,其工作不算成功。新西兰学者Ian H.Witten在其1976年的博士论文中第一次明确指出时序差分学习规则。Klopf的工作对Barto、Sutton和Anderson的启发很大,促使他们在20世纪80年代初将时序差分学习与试错学习结合,提出著名的“行动者评论者框架”(ActorCritic Architecture),时序差分的强化学习由此正式登场。然而,把时序差分与动态规划和试错方法全部整合在一起是在80年代末,归功于英国学者Chris J.Watkins在其1989年的博士论文中所提出的Q学习(QLearning)算法。1992年,国际商业机器公司(International Business Machines Corporation,IBM)的Gerald Tesauro利用时序差分构造多层神经网络TDGammon,并在古老的西洋双陆棋中战胜人类世界冠军,引起广泛关注,也使时序差分的强化学习方法广为人知。同年,Watkins和Peter Dayan给出Q学习方法收敛性的第一个严格证明,更加加深了人们对Q学习和强化学习的兴趣。当前,时序差分已从专注预测的TD(lambda)到预估决策控制一体的SARSA(lambda),Barto 和Sutton合著的《强化学习导论》(Reinforcement Learning: An Introduction)已成为机器学习领域的经典之作。

平行强化的体系

基于大规模多层人工神经元网络的深度学习的成功,特别是AlphaGo和Pluribus的巨大影响,使强化学习方法整体上登上了一个更新、更高的层次。然而,随着各色各样的深度强化学习(Deep Reinforcement Learning,DRL)和深度Q学习(Deep QLearning,DQL)等的不断涌现和广泛应用,数据再次成为重大问题,而且图1右边所示的强化学习大脑神经科学的部分内容,特别是Hebb学习规则的重新评估和计算复杂化与有效性问题,也更加引人注意。

在以试错法为主的先行后知强化学习中,因实验周期长、成本高,数据来源受“经济诅咒”的制约; 而在动态规划类的先知后行强化方法中,算法实施又遇“维数灾难”,导致其无效、不可行,TD强化学习,特别是TDGammon借助Self Play在一定程度上为解决数据生成和算法效率指明了一条道路,而AlphaGo和Pluribus进一步强化了这条道路的有效性。实际上,这是一条通过虚实平行运作,由“小数据”生成大数据,再与蒙特卡洛或各类决策树等有效搜索技术结合,从大数据中精炼出针对具体问题的“小智能”般的精确知识之道。人们应当通过知识图谱和知识范畴(Knowledge Categories)等工具,将这一数据生成和知识制造的过程形式化并加以软件定义,为强化学习系统组态的生成和实际应用的自动化创造基础。

此外,抽象数字化的强化学习还必须与大脑生物化的功能强化实现平行互联。除快慢过程的微分Hebb学习规则外,人们更应关注强化学习与动物的无条件/工具性反射、典型惯性和目标导向行为以及认知图(Cognitive Maps)生成构造等问题的内在关联,并应用于针对不同病状的各种机器人辅助和智能康复系统的设计、操作、监控和运维之中,以及更一般的脑与神经相关疾病的智能诊疗系统中。同时,强化学习机制应成为虚实互动的平行学习和平行大脑的核心基础,扩展突触可塑、Hedonis神经元、多巴胺神经元与响应、奖励预估误差机制、神经元行动评估结构等大脑神经基础构成问题的计算和智能研究手段,使人类生物智能与人工智能的研发更加密切地结合到一起。图2给出虚实互动、实践与理论融合的平行强化学习体系的基本框架,目前流行的数字双胞胎或数字孪生是其中的一个重要组成部分。平行强化学习的目的是通过交换世界实施“吃一堑、长一智”(在虚拟的人工世界吃一堑、吃多堑,在现实的自然世界长一智、长多智),降低成本,提升效益,克服“经济诅咒”和“维数灾难”,走向智能知行合一的机器强化学习。

图2强化学习的虚实互动平行体系框架

知行合一的智能

学习是人类获取知识的通用且可靠的途径,这是人类文明有史以来的共识与实践。强化学习是机器具有机器智能的基础且关键的手段,这是人工智能研究开创以来的认识与方向,在很大程度上,也是目前从事智能科学与技术研发工作者的共识。然而,要使强化学习真正成为机器学习的核心和通向智能机制和智能算法的基础与关键技术,从“不知对错、无论好坏”的先行后知与先知后行,到知行合一虚实互动的混合平行智能,仍有许多理论和实践的任务必须完成。

首先,强化学习面临的许多经典问题依然存在,并没有被彻底有效地解决,如“维数灾难”、信用分配、信息不完备、非稳环境、状态行动Space Tiling、探索与利用的矛盾(Exploration and Exploitation Dilemma)等,需要更加深入和系统的研究。其次,对目前广泛应用的各类基于深度学习的热点深度强化学习方法,其引人注目的“超人”表现源自于针对并解决特定问题,但这也正是其难以推广应用和普及的问题所在。必须考虑这些深度强化学习方法构建与应用过程的形式化和软件定义问题,从而使过程的迁移及其自动化成为可能,完成从特别应用到相对通用的转化。最后,必须引入针对强化学习的软硬件平台,边缘与云端的支撑环境和相应的开源基础设施,使强化学习在生产、商业、交通、健康、服务等领域的应用成为真正的必需和现实,不仅是强化学习,还有强化控制、强化管理、强化医疗、强化经济、强化法律、强化安保等,使它们成为一个有效且普适的智能工程项目。

为此,研究者们需要从更高、更广的角度重新审视强化学习的方法和技术,使其真正成为“人机结合、知行合一、虚实一体”的“合一体”的核心与关键,化智能代理(Agents)为知识机器人,深入推动和完善智能社会的知识自动化进程。

《强化学习》一书就是为此目的而撰写的。本书主要讲述了强化学习的基本原理和基本方法,基于强化学习的控制、决策和优化方法设计与理论分析,深度强化学习原理以及平行强化学习等未来强化学习的发展新方向,展示从先行后知,先知后行,再到知行合一的混合平行智能思路。本书可作为高等学校人工智能、机器学习、智能控制、智能决策、智慧管理、系统工程以及应用数学等专业的本科生或研究生教材,亦可供相关专业的科研人员和工程技术人员参考。

本书的写作计划自2015年开始,最初作为复杂系统管理与控制国家重点实验室相关团队和中国科学院大学计算机与控制学院的教材,后纳入“智能科学与系统”博士学位培养课程的选用教科书系列。当时,相关中英文的著作很少,但经过5年多的发展,强化学习的研究和教材状况已发生了天翻地覆的变化,为写作增加了许多变数。尽管作者与团队付出了相当多的心血和努力,但限于水平,仍有许多地方需要改进完善。

本书的出版得到了国家自然科学基金(61722312,61533019)资助,在此表示感谢。

本书在撰写过程中得到了北京科技大学宋睿卓教授、中南大学罗彪教授和广东工业大学刘德荣教授的大力支持,在此,对他们的指导深表感谢!本书的完成参阅了大量国内外学者的相关论著,均在参考文献中列出,在此,对这些论著的作者深表感谢!本书的写作得到了中国科学院自动化研究所复杂系统管理与控制国家重点实验室的许多同事支持,特别是助理工程师朱辽和杨湛宇,研究生谢玉龙、李俊松、李洪阳、李涛、王凌霄、王鑫、卢经纬、夏丽娜、杜康豪、王子洋、阎钰天、韩立元等。最后,感谢清华大学出版社贾斌先生在本书的编辑和出版过程中所给予的热心帮助。

对于书中出现的不妥之处,殷切希望广大读者批评指正。

魏庆来王飞跃中国科学院自动化研究所复杂系统管理与控制国家重点实验室北京怀德海智能学院2022年5月

|

|