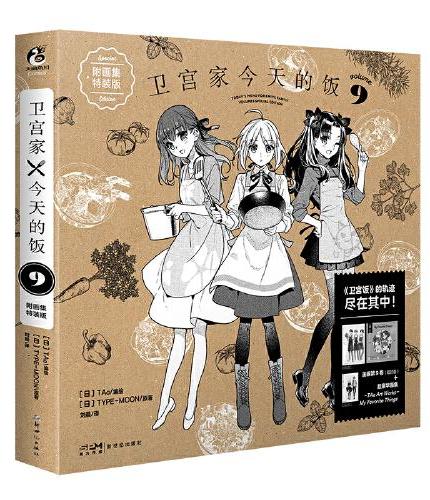

新書推薦: 《

卫宫家今天的饭9 附画集特装版(含漫画1本+画集1本+卫宫士郎购物清单2张+特制相卡1张)

》 售價:HK$

132.2

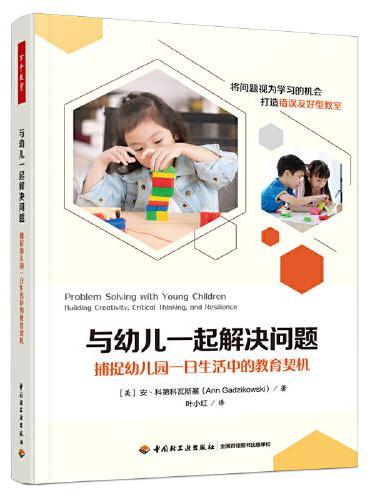

《

万千教育学前·与幼儿一起解决问题:捕捉幼儿园一日生活中的教育契机

》 售價:HK$

47.0

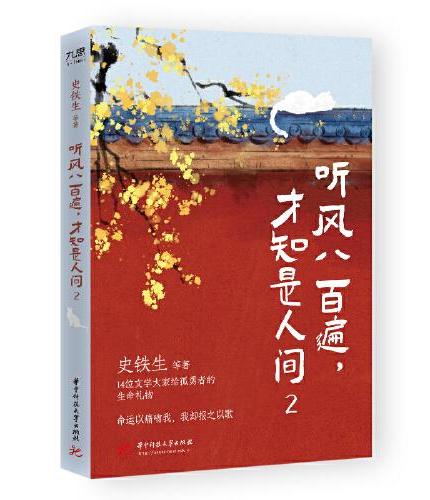

《

史铁生:听风八百遍,才知是人间(2)

》 售價:HK$

55.8

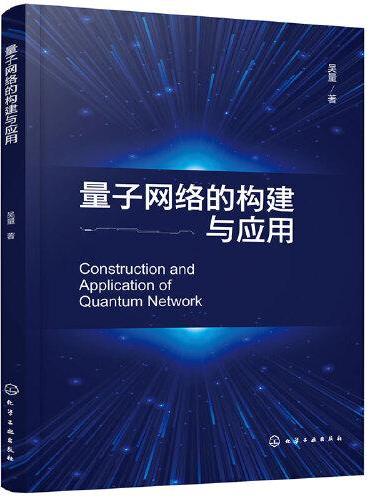

《

量子网络的构建与应用

》 售價:HK$

109.8

《

拍电影的热知识:126部影片里的创作技巧(全彩插图版)

》 售價:HK$

109.8

《

大唐名城:长安风华冠天下

》 售價:HK$

87.4

《

情绪传染(当代西方社会心理学名著译丛)

》 售價:HK$

88.5

《

中国年画 1950-1990 THE NEW CHINA: NEW YEAR PICTURE 英文版

》 售價:HK$

236.0

編輯推薦:

《Presto技术内幕》由浅入深地详细介绍了Presto

內容簡介:

Presto是专门为大数据实时查询计算而设计和开发的产品。由于Presto是基于Java语言开发的, 因此,对使用者和开发者而言, Presto极易学习、使用并针对特定的业务场景进行改造开发和性能 优化。无论是对多数据源支持,还是高性能、易用性、可扩展性等方面, Presto都是大数据实时查 询计算产品中的佼佼者。 本书按照由浅入深的顺序对Presto进行了全方位的细致讲解,具体内容包括Presto概述、 Presto安装与部署、 Presto RESTful框架解析、提交查询、生成查询执行计划、查询调度、查询执行、队列、System Connector、 Hive Connector、 Kafka Connector、 Connector开发、 Functions开发、 JD-Presto功能改造、 Presto性能调优、 Presto应用场景。 本书对Java研发工程师,在大数据技术领域从业的研发工程师、运维工程师、架构师,对大数 据研究方向感兴趣的大学老师和学生、以及大数据技术的入门学者,从事海量数据分析应用的开发 者、研究者都有很强的参考价值。

關於作者:

在数据洞察、数据分析、统计解析等领域具有丰富经验,现担任京东数据罗盘产品经理;京东易搜产品经理,曾担任香港上市企业数据分析师,国内最早一批的电商运营人员。乐于为商家提供数据分析、决策与指导建议。

目錄

第一部分 基础篇

內容試閱

为什么要写这本书